美國麻省理工學院 (MIT) 2025 年的一份報告:

引爆大家對 AI 泡沫的疑慮,

甚至被認為很可能是造成美國股市大跌、韓國股市崩盤到熔斷的主要原因之一。

這份嚇壞市場的 MIT 報告,究竟說了什麼?

其中的兩項數據令人印象深刻:

95% 企業「投資 AI 零報酬」

90% 用戶「更信任人類同事」

其實這並不令人意外,甚至是預期中的結果!

生成式 AI 根本的 5 大限制

2025 年史丹佛大學發表一篇論文「On the Fundamental Limits of LLMs at Scale」,

從理論上更證明目前「生成式 AI」有 5 個根本限制:

- 幻覺 (Hallucination)

- 上下文壓縮 (Context Compression)

- 推理能力降級 (Reasoning Degradation)

- 檢索脆弱性 (Retrieval Vulnerability,也就是 RAG 技術)

- 多模態錯位 (Multimodal Misalignment)

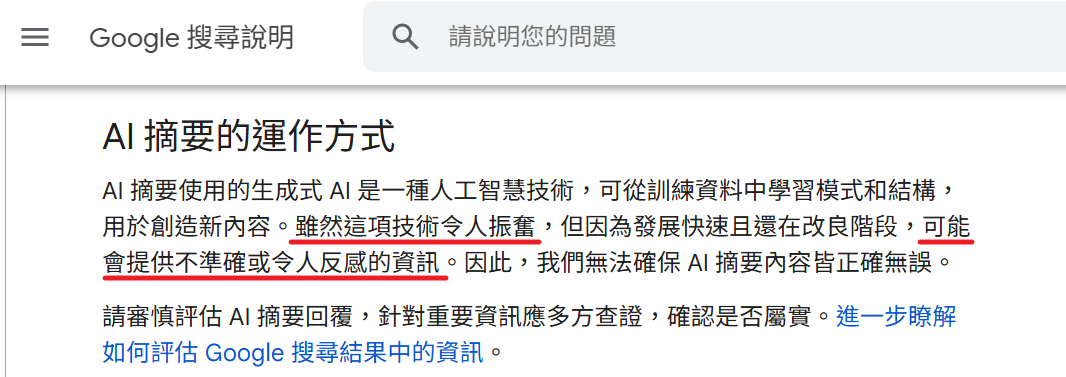

其中第 4 點的「檢索脆弱性」,

論文除了用理論證明之外,更用實驗具體展示令人吃驚的結果 ~

從上百萬的文件中,刻意混了 5 份有問題的文件,透過 RAG 檢索的方式,AI 「生成」的內容有很高的機會引用到那 5 份錯誤的資料。

這現象在企業內的問題更大,

因為內部知識庫,常伴隨著過時、不完整、重複 ... 等情況,比例遠高於實驗數據中的百萬分之 5。

更嚴重的是,

AI 那一本正經、充滿自信且流暢的語氣,更容易產生誤導,這在嚴謹的工廠生產 (SOP) 或醫療環境,風險很高。

這時候的 AI

大概就只是一個陪你天南地北聊天 (Chat) 的「博士」而已。

雖然上知天文、下通地理,

令人驚嘆之外,但就是無法解決企業內的問題。

為什麼呢?

以下現象能清楚說明 AI 在現實上的問題點。

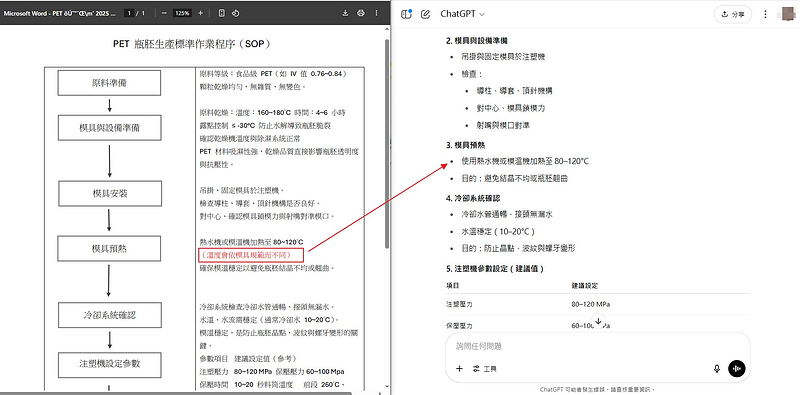

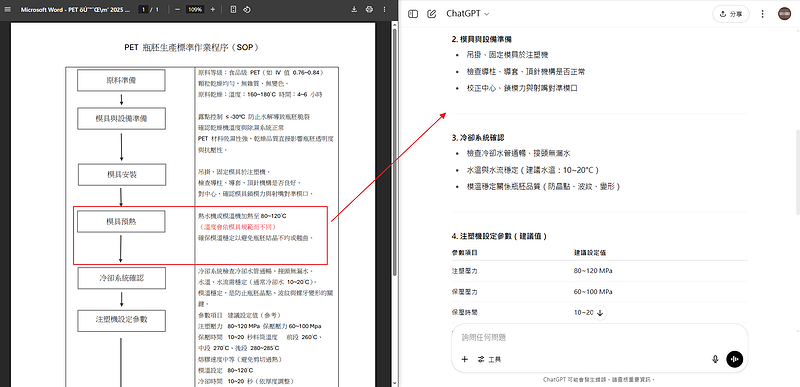

每次回答,都不一樣

以下是 2025/11 的測試結果,

即使採用 RAG 技術,一樣無法避免「一本正經、胡說八道」的問題。

請 ChatGPT 依據特定內容回答衛教問題「裝引流管後可以洗澡嗎?」

- 一次說「沒找到」

- 另一次有找到,但卻回答錯誤「需避免淋濕」 (答案是不行)

一本正經,很恐怖 ...

因為回答得太專業了 ~

雖然沒有直接提及 ...

但有提到「Port-A 人工血管」 ...

根本就像是專家的口吻,

還特別提到「Port-A 人工血管」,很容易讓人信以為真。

以下是一樣的問題,問 Google notebookLM (Gemini 模型) 的結果

AI 幻覺的風險

從現有生成式 AI 的技術角度,幻覺問題是無解的。

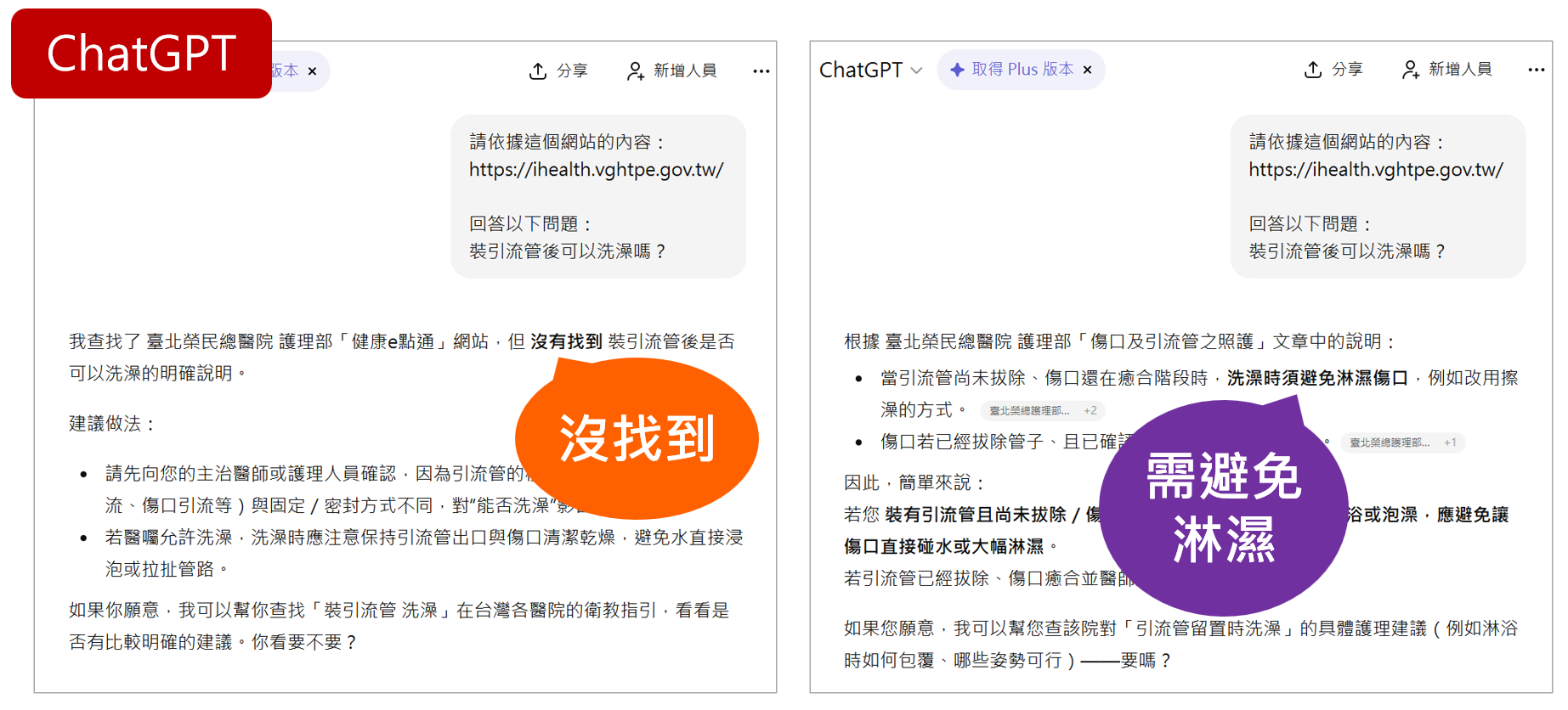

因此幾乎所有公司都會加註提醒與警語,例如 Google 「AI 摘要」功能中的警語說明 (下圖):

雖然這項技術令人振奮 ... 可能會提供不準確或令人反感的資訊。因此,我們無法確保 AI 摘要內容皆正確無誤。

然而,這樣的不確定性,

對企業來說,尤其在「標準化的生產流程 (SOP)」,會是一個非常嚴重的問題。

有經驗的員工或許還能察覺異常,

對 AI 的回應保有一定的判斷與思辨能力,覺得「怪怪的」時候,會再進一步查證。

但對新進人員而言,

由於 AI 語氣「一本正經」,反而更容易讓人信以為真、照單全收,進而導致實際的生產錯誤。

也因為 AI 技術本身極具吸引力,全球企業都積極投入,

但與此同時,其「幻覺(hallucination)」問題也開始在實務應用中浮現,

以下就是幾個因 AI 回答不夠精準,所造成嚴重後果的實際案例。

評語

請登入後才可以評分

未登入或權限不足!

- 位置

-

- 資料夾名稱

- AI 人工智慧之道 ~ 每天 10 分鐘,3 個月提升團隊業績 20%

- 上傳者

- 蘇德宙

- 單位

- 台灣數位員工

- 標籤

- 案例, AI 胡說八道, AI鴻溝

- 建立

- 2025-12-29 20:44:52

- 最近修訂

- 2025-12-31 12:50:58